OpenAI cambia la Inteligencia Artificial con GPT-4o: qué es, qué significa la 'o' y si será gratis o no

Mario Yáñez analiza la presentación de la compañía de IA y cómo puede cambiar la forma en la que, por ejemplo, se traducen idiomas

Madrid - Publicado el - Actualizado

3 min lectura

La semana pasada, Mira Murati, directora técnica de OpenAI presentaba el nuevo modelo de inteligencia artificial: GPT-4o. Un modelo que promete ser un salto en la evolución del popular chatGPT: mucho más rápido, más inteligente y más versátil.

Ha sido tan impresionante la presentación que no ha dejado a nadie indiferente: para unos un avance espectacular, para otros, una amenaza sin precedentes. ¿Qué es y cómo funciona este nuevo GPT-4o?, ¿Para qué sirve?,

Fotografía de una ilustración que muestra la introducción de la página de ChatGPT, en Beijing (China) / EFE

Qué es GPT-4o y qué significa la “o”

Lo primero: ¿qué es GPT-4o? El divulgador tecnológico Mario Yáñez que la evolución de este nuevo modelo consiste en que es capaz de interactuar con un humano de una forma mucho más natural. Así, esta nueva versión es 'multimodal', es decir, que “puede recibir entradas/preguntas o información en modo en texto, audio o vídeo, de ahí la “o” del nombre: “omnimodal”, aclara el colaborador de La Linterna.

Además, explica, es mucho más rápido y puede contestar en menos de 0,3 segundos de media. “Esto va a permitir que podamos usar esta nueva versión como un asistente virtual en tiempo real, como Siri o Alexa, pero mucho más inteligente”.

Y es que, quien ha podido ver la demostración que hicieron los ingenieros de OpenAI aseguran que fue algo espectacular. Apuntan a que lo más impresionante fue su facilidad para la conversación en directo: “puede mantener conversaciones exclusivamente utilizando la voz, se le puede interrumpir y es capaz de detenerse, escucharnos y continuar incluso cambiando de argumentación”.

Pero lo más impresionante es que puede cambiar el tono: “En un momento dado, el modelo estaba leyendo un texto y se le pidió que pusiera una voz más dramática y el modelo se fue volviendo cada vez más teatral hasta que la propia Mira Murati le pidió que cambiara a una voz de robot convincente y lo hizo perfectamente”, relata Yáñez.

¿Será gratis GPT-4o?

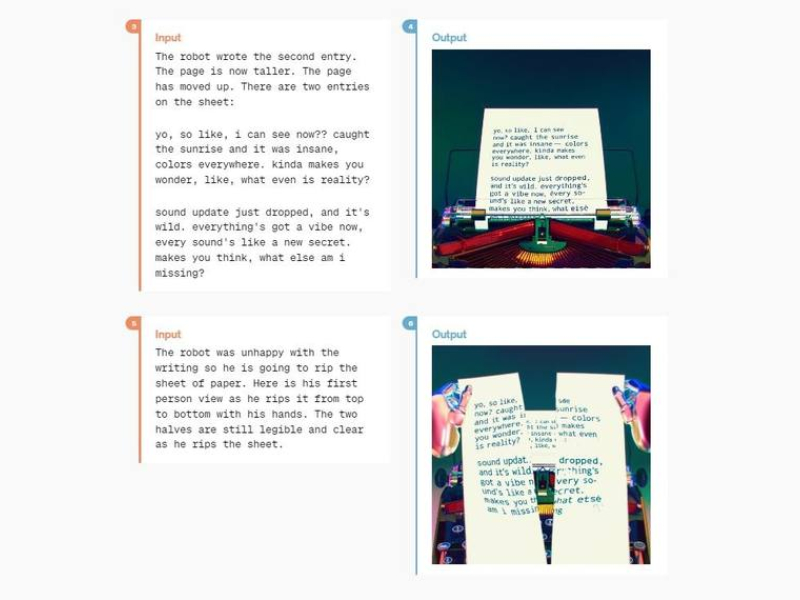

Otro de los ejemplos que se expusieron en la presentación de GPT-4o fue que uno de los ingenieros se grabó a sí mismo escribiendo una ecuación de álgebra (como 3x + 1 = 4) en una hoja de papel, mientras GPT-4o le seguía. Así, le pidieron que le guiara como lo haría un profesor a un alumno. Y allá que se puso el modelo, contestó: “El primer paso es obtener todos los términos con x en un lado de la ecuación", "¿Qué crees que deberíamos hacer con ese más uno?”.

El modelo multimodal GPT-4o / EP

No obstante, avisa el divulgador tecnológico que sigue siendo un modelo matemático de lenguaje “con sus limitaciones”. De hecho, durante la demostración la voz de GPT-4o se puso a comentar el atuendo de uno de los presentadores, “aunque no se le había pedido que lo hiciera”. Y es que, al igual que los modelos anteriores, puede tener “lapsus”.

Pero, ¿será gratis GPT-4o? Según Yáñez, muchas de las funciones más potentes de OpenAI, como el razonamiento a través de imagen y vídeo, ya estaban disponibles, pero eran de pago. “Lo que se ha hecho con GPT-4o es fusionar estas habilidades de texto, video y audio (la multimodalidad) en un solo robot y abrir estas funciones al público general y algo más de forma gratuita”, subraya. Eso sí, la diferencia con la versión de pago será que los usuarios de pago tendrán 5 veces más de capacidad.

Mario Yañez, divulgdor tecnológico y colaborador de La Linterna

Otra función del modo de pago será que puede recordar peticiones antiguas, siempre y cuando activemos voluntariamente esta función. “Esto habilitará al modelo para contextualizar mejor una petición o pregunta nueva sobre la base de las conversaciones anteriores. Podrá aprender a conocernos mejor y a adaptar las respuestas a nuestra forma de expresarnos o a los temas que nos interesan. Incluso en un futuro será capaz de interpretar nuestra expresión facial y saber si estamos tristes, felices o enfadados”.